So optimieren Sie Ihre WordPress Robots.txt für SEO

Kürzlich fragte uns einer unserer Leser nach Tipps, wie man die robots.txt-Datei optimieren kann, um die SEO zu verbessern.

Die robots.txt-Datei teilt den Suchmaschinen mit, wie sie Ihre Website crawlen sollen, was sie zu einem unglaublich mächtigen SEO-Tool macht.

In diesem Artikel zeigen wir Ihnen, wie Sie eine perfekte robots.txt-Datei für SEO erstellen.

Was ist eine robots.txt-Datei?

Robots.txt ist eine Textdatei, die Website-Besitzer erstellen können, um Suchmaschinen-Bots mitzuteilen, wie sie die Seiten auf ihrer Website crawlen und indizieren sollen.

Sie wird in der Regel im Stammverzeichnis, auch bekannt als Hauptordner, Ihrer Website gespeichert. Das grundlegende Format für eine robots.txt-Datei sieht wie folgt aus:

User-Agent: [Name des Benutzer-Agenten] Nicht zulassen: [URL-String, der nicht gecrawlt werden soll] Benutzer-Agent: [user-agent name] Erlauben: [URL-String, der gecrawlt werden soll] Sitemap: [URL Ihrer XML-Sitemap]

Sie können mehrere Zeilen mit Anweisungen haben, um bestimmte URLs zu erlauben oder zu verbieten und mehrere Sitemaps hinzuzufügen. Wenn Sie eine URL nicht verbieten, gehen Suchmaschinen-Bots davon aus, dass sie diese crawlen dürfen. So kann eine robots.txt-Beispieldatei aussehen:

User-Agent: * Erlauben: /wp-content/uploads/ Nicht zulassen: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/ sitemap_index.xml

Im obigen robots.txt-Beispiel haben wir Suchmaschinen erlaubt, Dateien in unserem WordPress-Uploads-Ordner zu crawlen und zu indizieren.

Danach haben wir Suchbots das Crawlen und Indizieren von Plugins und WordPress-Administrationsordnern untersagt.

Zum Schluss haben wir die URL unserer XML-Sitemap angegeben.

Brauchen Sie eine Robots.txt-Datei für Ihre WordPress-Site?

Wenn Sie keine robots.txt-Datei haben, wird Ihre Website trotzdem von Suchmaschinen gecrawlt und indiziert. Sie können den Suchmaschinen jedoch nicht mitteilen, welche Seiten oder Ordner nicht gecrawlt werden sollen. Dies hat keine große Auswirkung, wenn Sie zum ersten Mal einen Blog starten und noch nicht viele Inhalte haben.

Wenn Ihre Website jedoch wächst und Sie viele Inhalte haben, werden Sie wahrscheinlich eine bessere Kontrolle darüber haben wollen, wie Ihre Website gecrawlt und indiziert wird.

Hier ist der Grund dafür.

Suchroboter haben eine Crawl-Quote für jede Website.

Das bedeutet, dass sie eine bestimmte Anzahl von Seiten während einer Crawl-Sitzung crawlen. Wenn sie nicht alle Seiten auf Ihrer Website fertig crawlen, kommen sie zurück und setzen das Crawlen in der nächsten Sitzung fort. Dies kann die Indizierungsrate Ihrer Website verlangsamen.

Sie können dies beheben, indem Sie den Suchrobotern verbieten, unnötige Seiten wie Ihre WordPress-Admin-Seiten, Plugin-Dateien und Themes-Ordner zu crawlen.

Indem Sie unnötige Seiten verbieten, sparen Sie Ihre Crawl-Quota. Dies hilft den Suchmaschinen, noch mehr Seiten auf Ihrer Website zu crawlen und sie so schnell wie möglich zu indizieren.

Ein weiterer guter Grund, die robots.txt-Datei zu verwenden, ist, wenn Sie Suchmaschinen davon abhalten möchten, einen Beitrag oder eine Seite auf Ihrer Website zu indizieren.

Es ist nicht der sicherste Weg, um Inhalte vor der Öffentlichkeit zu verbergen, aber es wird Ihnen helfen, zu verhindern, dass sie in den Suchergebnissen erscheinen.

Wie sieht eine ideale Robots.txt-Datei aus?

Viele beliebte Blogs verwenden eine sehr einfache robots.txt-Datei. Ihr Inhalt kann variieren, je nach den Bedürfnissen der jeweiligen Website:

User-Agent: * Disallow: Sitemap: http://www.example.com/ post-sitemap.xml Inhaltsübersicht: http://www.example.com/ page-sitemap.xml

Diese robots.txt-Datei erlaubt allen Bots die Indizierung aller Inhalte und liefert ihnen einen Link zu den XML-Sitemaps der Website.

Für WordPress-Sites empfehlen wir die folgenden Regeln in der robots.txt-Datei:

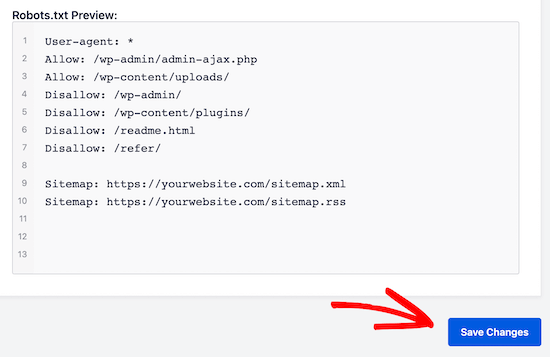

User-Agent: * Erlauben: /wp-content/uploads/ Nicht zulassen: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Inhaltsverzeichnis: http://www.example.com/post-sitemap.xml Inhaltsübersicht: http://www.example.com/page-sitemap.xml

Dies weist Suchbots an, alle WordPress-Bilder und -Dateien zu indizieren. Es verbietet Suchbots die Indizierung von WordPress-Plugin-Dateien, des WordPress-Administrationsbereichs, der WordPress-Readme-Datei und von Affiliate-Links. Durch das Hinzufügen von Sitemaps zur robots.txt-Datei machen Sie es den Google-Bots leicht, alle Seiten auf Ihrer Website zu finden.

Da Sie nun wissen, wie eine ideale robots.txt-Datei aussieht, lassen Sie uns einen Blick darauf werfen, wie Sie eine robots.txt-Datei in WordPress erstellen können.

Wie erstellt man eine robots.txt-Datei in WordPress?

Es gibt zwei Möglichkeiten, eine robots.txt-Datei in WordPress zu erstellen. Sie können die Methode wählen, die für Sie am besten funktioniert.

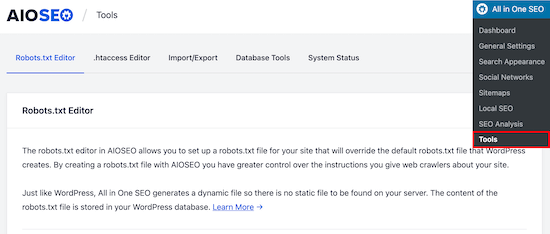

Methode 1: Bearbeiten der Robots.txt-Datei mit All in One SEO

All in One SEO, auch bekannt als AIOSEO, ist das beste WordPress-SEO-Plugin auf dem Markt, das von über 2 Millionen Websites verwendet wird.

Es ist einfach zu bedienen und kommt mit einem robots.txt-Datei-Generator.

Wenn Sie das AIOSEO-Plugin noch nicht installiert haben, können Sie sich unsere Schritt-für-Schritt-Anleitung zur Installation eines WordPress-Plugins ansehen.

Hinweis: Die kostenlose Version von AIOSEO ist ebenfalls verfügbar und verfügt über diese Funktion.

Sobald das Plugin installiert und aktiviert ist, können Sie damit Ihre robots.txt-Datei direkt aus Ihrem WordPress-Adminbereich erstellen und bearbeiten.

Gehen Sie einfach zu All in One SEO " Tools, um Ihre robots.txt-Datei zu bearbeiten.

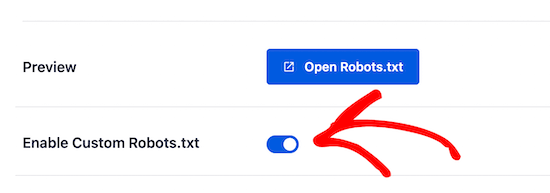

Zuerst müssen Sie die Bearbeitungsoption aktivieren, indem Sie den Schalter "Enable Custom Robots.txt" auf blau setzen. Wenn dieser Schalter aktiviert ist, können Sie eine benutzerdefinierte robots.txt-Datei in WordPress erstellen.

All in One SEO zeigt Ihre vorhandene robots.txt-Datei im Abschnitt "Robots.txt-Vorschau" am unteren Rand Ihres Bildschirms an. Diese Version zeigt die Standardregeln, die von WordPress hinzugefügt wurden.

Diese Standardregeln weisen die Suchmaschinen an, Ihre WordPress-Kerndateien nicht zu crawlen, erlauben den Bots, alle Inhalte zu indizieren, und bieten ihnen einen Link zu den XML-Sitemaps Ihrer Website.

Jetzt können Sie Ihre eigenen benutzerdefinierten Regeln hinzufügen, um Ihre robots.txt für SEO zu verbessern.

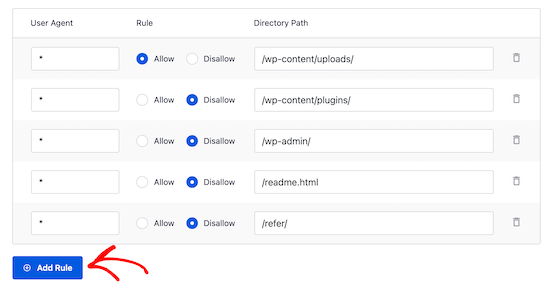

Um eine Regel hinzuzufügen, geben Sie einen User Agent in das Feld "User Agent" ein. Wenn Sie ein * verwenden, wird die Regel auf alle User Agents angewendet.

Wählen Sie dann aus, ob Sie den Suchmaschinen das Crawlen "erlauben" oder "verbieten" möchten.

Geben Sie anschließend den Dateinamen oder den Verzeichnispfad in das Feld "Verzeichnispfad" ein.

Die Regel wird automatisch auf Ihre robots.txt angewendet. Um eine weitere Regel hinzuzufügen, klicken Sie auf die Schaltfläche "Add Rule" (Regel hinzufügen).

Wir empfehlen das Hinzufügen von Regeln, bis Sie das ideale robots.txt-Format erstellt haben, das wir oben beschrieben haben. Ihre benutzerdefinierten Regeln werden wie folgt aussehen.

Wenn Sie fertig sind, vergessen Sie nicht, auf die Schaltfläche "Änderungen speichern" zu klicken, um Ihre Änderungen zu speichern.

Methode 2. Manuelles Bearbeiten der Datei Robots.txt mit FTP

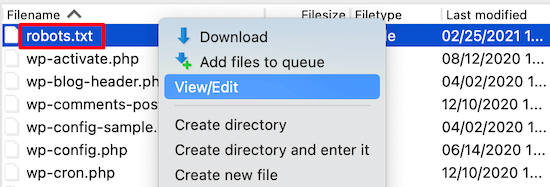

Für diese Methode müssen Sie einen FTP-Client verwenden, um die robots.txt-Datei zu bearbeiten.

Verbinden Sie sich einfach mit Ihrem WordPress-Hosting-Konto mit einem FTP-Client.

Sobald Sie drin sind, können Sie die robots.txt-Datei im Stammordner Ihrer Website sehen.

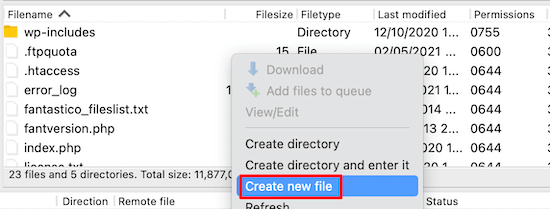

Wenn Sie keine sehen, dann haben Sie wahrscheinlich keine robots.txt-Datei. In diesem Fall können Sie einfach loslegen und eine erstellen.

Robots.txt ist eine reine Textdatei. Sie können sie auf Ihren Computer herunterladen und mit einem beliebigen Texteditor wie Notepad oder TextEdit bearbeiten.Nachdem Sie Ihre Änderungen gespeichert haben, können Sie sie wieder in das Stammverzeichnis Ihrer Website hochladen.

Wie testen Sie Ihre robots.txt-Datei?

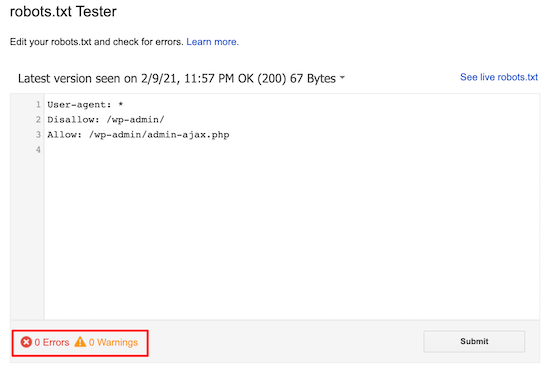

Sobald Sie Ihre robots.txt-Datei erstellt haben, ist es immer eine gute Idee, sie mit einem robots.txt-Tester-Tool zu testen.

Es gibt viele robots.txt-Tester-Tools, aber wir empfehlen die Verwendung des Tools in der Google Search Console.

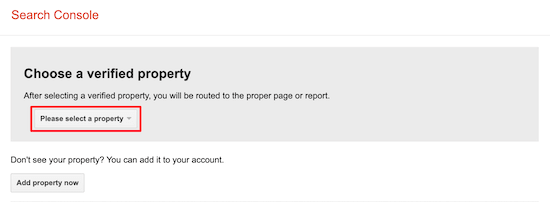

Zunächst müssen Sie Ihre Website mit der Google Search Console verknüpfen. Wenn Sie dies noch nicht getan haben, lesen Sie unsere Anleitung, wie Sie Ihre WordPress-Website zur Google Search Console hinzufügen. Dann können Sie das Google Search Console Robots Testing Tool verwenden.

Wählen Sie einfach Ihre Immobilie aus der Dropdown-Liste aus. Das Tool holt automatisch die robots.txt-Datei Ihrer Website und markiert die Fehler und Warnungen, wenn es welche gefunden hat.

Abschließende Überlegungen

Das Ziel der Optimierung Ihrer robots.txt-Datei ist es, Suchmaschinen daran zu hindern, Seiten zu crawlen, die nicht öffentlich zugänglich sind. Zum Beispiel Seiten in Ihrem wp-plugins-Ordner oder Seiten in Ihrem WordPress-Admin-Ordner. Ein verbreiteter Mythos unter SEO-Experten ist, dass das Blockieren von WordPress-Kategorie-, Tag- und Archivseiten die Crawl-Rate verbessert und zu einer schnelleren Indizierung und höheren Rankings führt. Dies ist nicht wahr. Es verstößt auch gegen die Webmaster-Richtlinien von Google.

Wir empfehlen, dass Sie das obige robots.txt-Format befolgen, um eine robots.txt-Datei für Ihre Website zu erstellen.

Wir hoffen, dass dieser Artikel Ihnen geholfen hat zu lernen, wie Sie Ihre WordPress robots.txt-Datei für SEO optimieren können.